Verbeteren van de crawlbaarheid van je website is cruciaal voor een goede online aanwezigheid. Het zorgt ervoor dat zoekmachines jouw pagina’s gemakkelijk kunnen vinden en indexeren. Een goede crawlbaarheid betekent betere rankings, wat kan leiden tot meer verkeer. In dit artikel deel ik mijn ervaringen en tips om de crawlbaarheid van jouw website te verhogen.

Wat is crawlbaarheid?

Crawlbaarheid verwijst naar het vermogen van zoekmachines zoals Google om jouw website te doorzoeken en te begrijpen. Als je website niet goed gecrawld kan worden, zullen je pagina’s niet in de zoekresultaten verschijnen. Een goede crawlbaarheid is dus essentieel voor jouw SEO-strategie.

Hoe werkt het crawlen?

Zoekmachines zoals Google gebruiken webcrawlers of ‘spiders’ om internetpagina’s te ontdekken. Deze crawlers volgen links van pagina naar pagina en verzamelen data over de inhoud en structuur van websites. Hoe beter deze crawlers jouw website kunnen begrijpen, hoe hoger je in de zoekresultaten kunt komen.

Belang van crawlbaarheid

Een goede crawlbaarheid zorgt ervoor dat:

- Je pagina’s sneller worden geïndexeerd.

- Je kunt profiteren van organisch verkeer.

- Zoekmachines beter begrijpen waar jouw pagina’s over gaan.

Om dit te bereiken, zijn er verschillende stappen die je kunt ondernemen.

Zorg voor een duidelijke structuur

Lees ook: Wat zijn goede backlinks waard

Gebruik een logische navigatie

Een duidelijke navigatie is essentieel voor een goede crawlbaarheid. Zorg ervoor dat bezoekers en crawlers eenvoudig door je website kunnen navigeren. Denk hierbij aan een menustructuur die logisch in elkaar zit.

Voorbeeld van een goede navigatie:

- Hoofdcategorieën

- Subcategorieën

- Producten of diensten

- Subcategorieën

XML-sitemaps

Een XML-sitemap is een bestand waarin je alle relevante pagina’s van je website vermeldt. Door een sitemap aan te maken, help je zoekmachines jouw website beter te begrijpen. Dit bestand geeft aan welke pagina’s belangrijk zijn en wanneer deze zijn bijgewerkt.

Handige link: Crawling & indexatie: hoe zit dat eigenlijk? – Hypershop

Robots.txt bestand

Met een robots.txt bestand kun je aangeven welke delen van je website je wilt laten crawlen en welke niet. Dit is een krachtig hulpmiddel om de crawlbaarheid te sturen. Zorg ervoor dat je belangrijke pagina’s niet per ongeluk blokkeert.

Optimaliseer je URL-structuur

Gebruik duidelijke en beschrijvende URL’s

Een goede URL-structuur is een must voor de crawlbaarheid van je website. Houd je URL’s kort, eenvoudig en relevant. Dit helpt niet alleen crawlers, maar ook gebruikers om snel te begrijpen waar de pagina over gaat.

Voorbeeld van een goede URL:

- Slecht:

www.jouwsite.com/p12345 - Goed:

www.jouwsite.com/schoenen/dames/rode-sneakers

Gebruik van hyphens

Bij het maken van URL’s is het gebruik van hyphens (streepjes) beter dan underscores (_). Crawlers interpreteren hyphens als spaties, waardoor ze de woorden in de URL beter kunnen begrijpen.

Verbeter je laadtijd

Paginasnelheid en crawlbaarheid

De snelheid van je website is niet alleen belangrijk voor gebruikerservaring, maar ook voor crawlbaarheid. Langzame laadtijden kunnen ervoor zorgen dat crawlers niet alle pagina’s op je site bezoeken. Dit kan leiden tot lagere indexering.

Tools voor snelheidstests

Met verschillende tools kun je de laadsnelheid van je website testen. Enkele populaire tools zijn:

- Google PageSpeed Insights

- GTmetrix

- Pingdom

Optimaliseer afbeeldingen

Afbeeldingen kunnen zwaar zijn en de laadtijd van je website beïnvloeden. Zorg ervoor dat je afbeeldingen comprimeert zonder kwaliteitsverlies. Dit betekent snellere laadtijden en een betere crawlbaarheid.

Interne links

Kracht van interne links

Interne links zijn links die van de ene pagina van je website naar de andere leiden. Ze helpen zoekmachines te begrijpen hoe pagina’s met elkaar zijn verbonden. Hoe meer interne links naadloos naar relevante inhoud leiden, hoe beter de crawlbaarheid.

Goede interne linkstructuren

Gebruik desnoods een spreadsheet om je interne linkstructuren te beheren. Zorg ervoor dat iedere pagina minimaal één interne link richting een andere pagina heeft. Voorkom te veel diepere lagen binnen de site, zodat crawlers minder moeite hebben met navigeren.

Vermijd duplicate content

Wat is duplicate content?

Duplicate content verwijst naar inhoud die op meerdere URL’s op het web aanwezig is. Dit kan verwarrend zijn voor zoekmachines, en ze kunnen ervoor kiezen om slechts één versie te indexeren.

Hoe kan je duplicate content voorkomen?

Er zijn verschillende manieren om duplicate content te vermijden:

- 301 redirects: Leid oudere of dubbele pagina’s naar de juiste versie.

- Canonical tags: Gebruik deze tags om aan te geven welke versie van een pagina als de originele moet worden beschouwd.

Controleer regelmatig

Regelmatig controleren op duplicate content is essentieel. Er zijn verschillende tools beschikbaar, zoals Siteliner en Copyscape, die je hierbij kunnen helpen.

Gebruik gestructureerde data

Wat is gestructureerde data?

Gestructureerde data is een manier van gegevensindeling die zoekmachines helpt om je inhoud beter te begrijpen. Door gestructureerde gegevens toe te voegen, kun je de zichtbaarheid van je pagina’s in zoekresultaten verbeteren.

Hoe implementeer je gestructureerde data?

Gestructureerde data kan worden geïmplementeerd met schema markup. Hiermee geef je context aan je inhoud en maak je het makkelijker voor zoekmachines om relevante informatie te extraheren.

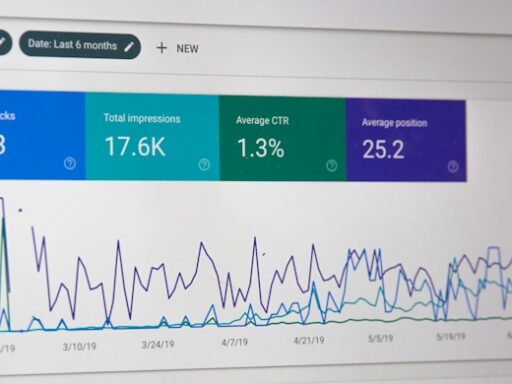

Monitor crawlgedrag

Analyseer je Google Search Console

Een van de beste manieren om je crawlbaarheid te monitoren, is via Google Search Console. Hier kun je zien hoe goed jouw site wordt gecrawld en welke pagina’s problemen ondervinden.

Crawl statistieken

Je kunt specifieke statistieken bekijken, zoals:

- Aantal gecrawlde pagina’s per dag.

- Fouten die tijdens het crawlen zijn ontstaan.

- Welke pagina’s het meest bezocht worden door crawlers.

Verbeter waar nodig

Evalueer regelmatig de data en pas je strategie aan. Als je ziet dat bepaalde pagina’s niet worden gecrawld, probeer dan te achterhalen waarom dat zo is. Dit kan een verstoorde linkstructuur of een .robots.txt-bestand zijn.

Interessante info: Crawlers: optimaliseer de vindbaarheid van je website – Leadi

"Optimalisatie is geen eindpunt, maar een continu proces van leren en verbeteren."

Verhoog gebruiksvriendelijkheid

Responsive design

Een responsieve website zorgt voor een betere gebruikerservaring op verschillende apparaten. Crawlers waarderen websites die mobiel-vriendelijk zijn. Zorg ervoor dat je website goed functioneert op tablets en smartphones.

Vermijd pop-ups

Pop-ups kunnen crawlers afleiden en zelfs blokkeren. Ze kunnen er ook voor zorgen dat gebruikers je site verlaten. Beperk het gebruik van pop-ups voor een betere crawlbaarheid.

Veelgestelde vragen

Wat is crawlbaarheid?

Crawlbaarheid verwijst naar het vermogen van zoekmachines om een website te doorzoeken en te indexeren.

Hoe kan ik mijn crawlbaarheid verbeteren?

Je kunt dit verbeteren door een duidelijke structuur te gebruiken, een XML-sitemap te maken, en je pagina’s te optimaliseren voor snelheid en mobiele apparaten.

Wat is een robots.txt bestand?

Een robots.txt bestand is een tekstbestand dat zoekmachines instrueert welke delen van je site ze wel of niet kunnen crawlen.

Waarom is interne linkbuilding belangrijk?

Interne linkbuilding helpt zoekmachines de structuur van je website beter te begrijpen en verhoogt de kans dat pagina’s worden gecrawld.